张磊 机器学习爱好者 人工智能爱好者社区专栏作者

知乎:https://zhuanlan.zhihu.com/c_184412713

个人网站:novasky.top

GitHub:https://github.com/zlxy9892

17世纪莱布尼茨设想,能否创造一种通用科学语言,可以把推理的过程,象数学一样用公式进行计算。随着计算机诞生,自动化的普及 ,通用人工智能再次受到关注,什么样的方法可以实现AGI?

研究方向

Natural language processing:弗雷格指出:“词句在语境中才有意义”,语境是个让人崩溃的问题,所以被学者搁置,直接将文字作为研究方向。文字作为思维生成的符号,就像电脑显示器呈现的图像,事实上,图像是主机发出的讯号,讯号的背后是各种不同软件的逻辑。人也一样,聊天不是用嘴巴在说、图像不是用眼睛在看,一切都是大脑,感官只是信号的输出、接收器。通过屏幕(语言)研究软件(思维)隔着一个屏障。也许能从显示器颜色得出一些逻辑,但探索是什么软件,软件逻辑代码是什么,几乎没可能性

NLP的方法仅实用翻译,就像Photoshop滤镜功能,可以把一张油画(英语)转换成素描(汉语),软件不改变画面内容,但不理解画的内容

Machine Learning:学习的词义是指学习未知逻辑,ML取名时用了个形容词,只是统计学的一个分支,统计学作为一门学科之所以诞生,是因为事物复杂到不知道、或者不清晰发展的逻辑,只能通过表象判断结果。ML知道a+b等于2的概率有多大,但不知道也没考虑过1+1等于多少,如果ML的算法和人脑思维方式没关系,如何与人交互?任何事物产生结果前都有非常复杂的过程,且这个过程有很长时间,ML是统计事物结果的利器,但不能实现AGI

AI是否可能具有学习能力?人类的大脑探索世界获取知识,和人类创造一个”大脑“,这个”大脑“能探索世界获取知识,难度上是完全不一样的概念!前者是上帝的成就,后者是人类的成就,说AI可能具有学习功能,或者说AI可以超越人类…等于在说人类可以超越“上帝”。代码能解析已经写好的逻辑判断,但不可能理解、衍生出新的逻辑,世界上只有一种机器才能衍生出无数的逻辑,就是人脑,AI具有学习能力的几率,比无限猴子理论还低,因为理解其它逻辑的可能性,被限制在一套代码里,没自然选择论那样自由…

我们看看电影《夏洛特的网》第一句台词,女儿说:”你要做什么“,这句话对AI有多复杂。

这里只概括几个问题,如果细化会有数万条,缺了任意一个,人机交互就无法进行,什么样的算法可以解决几个词的问题?NLP,ML让大众误解,是因为算法很复杂,对话几个字很简单,复杂与简单对比,自然信以为真,不知到几个字,触发了自己大脑多么复杂的逻辑,也不知道,AI表达没有意义、被设定好的字符,自己大脑赋予了它意义…甚至赋予了感情

要实现AGI,就必须将人的思维作为研究方向,但脑科学的发展还处在天圆地方阶段,多数理论模糊不清,且存在矛盾,这是个很大的麻烦。本文提出利用计算机构建大脑思维框架的概念,将HCI、大脑思维逻辑逐步整合在这个框架里,验证准确性,当这套系统逐渐完善,人脑思维的原理就会逐渐明了,AGI也随之实现

构思概叙

人的大脑由~1000亿个神经元构成我们的意识,每个神经元由~2000分支构成,记忆、逻辑、价值观都是大脑神经元所处理,当大脑学习知识就会存储在某个神经元中,形成记忆。对某件事情有新的看法、逻辑...神经元分支就会建立新的序列,形成逻辑。所以神经元是记忆,神经元分支链接是逻辑,神经元的活动是运行

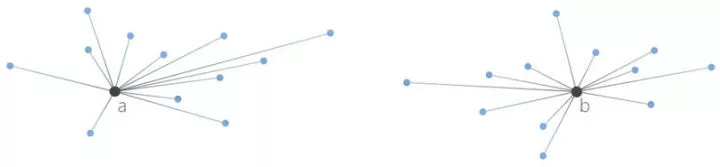

计算:集合(大脑记忆)作为根,函数(大脑逻辑)计算集合。<下图>a、b黑点代表2个集合(神经元),蓝线代表集合的子集(神经元分支),a子集碰到b子集,就会互相产生变量,a、b2个集合得出函数值,这个新函数值就是新集合,子集之间无限施加变量,时间是变量的标尺

任何公式都由计算元素和公式(逻辑)组成,拿0+1=1作比方,等式的元素:0、+、1、=、1 ,在本设计框架比喻AI的集合,0+1=1公式的逻辑比喻AI的函数。如果符号{0}代表我的集合,{1}代表世界集合,{+}代表我与世界关系的集合,那么我的函数值是:{0}{+}{1}={1},意思是我和世界产生影响后,我变化的结果,本文用{0}和{0}{+}{1}={1}构建AI的一切意识、行为,语言是在“叙述”这组公式,下面将{0}进行无限小细分,它的极限是多少,取决于我们对AI的智力要求多高

备注:符号{0}{+}{1}={1}下面会用别的符号代替

记忆(集合)

集合构成三大形式:实体集合、空间集合、时间集合

一 . 实体集合:

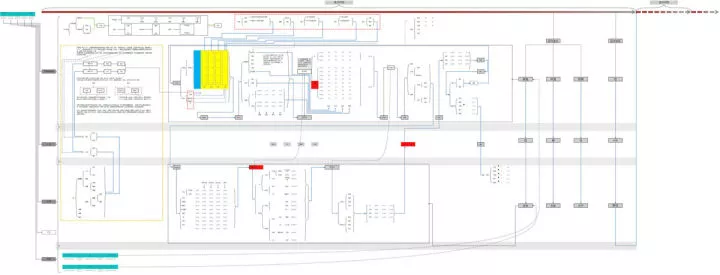

下图填红色,AI的{意识}同人一样,意识即"我思故我在",客观世界所有一切都装在AI的意识里面,包括自己的身体和逻辑。感官是客观世界与{世界}的讯息接口 ,如果人的大脑没通过感官了解自己身体,那么身体的存在与否,意识不会知道,比如医疗幻肢现象:被截肢的军人,手术前如果不知道截肢,那么醒来,他会感觉到脚还存在,病人的脚被截肢,不等于大脑控制脚的神经元被删除!

备注:下图虚线表示的结构集合并不存在,标识只是方便阅读

下图填黄色,{Theodore}作为人,他的集合和AI的集合几乎一模一样,并且{Theodore}是Samantha (AI){意识}的子集!因为涉及到交互计算,如果Samantha的{意识}不了解Theodore,没法计算。{Theodore}的子集是否存在于Samantha的意识,取决于2个因素:1.客观上Theodore的知识量有多少,2.主观上Samantha对Theodore的了解度,下图黄色虚线框:Samantha认识了多少用户,就记录多少人…实体集合初步估计约100万以上,可满足通用AI的需求

备注:划分人与AI的集合属于关系有些非主流,笔者的理解是人的皮肤、肌肉、骨骼…等一切都依附在神经系统上。集合符号用{ }内数字加-表示,如:{01-07-12}代表退的集合,后一行数字是前一行数字的子集,如果第一行数字01代表人,第二行07代表腿,第三行12不可能代表腿以外任何部位

二 .空间集合:上图的实体集合图,因Excel限制,是平面的,实体集合需要定位在3D空间,类似Google Earth

三. 时间集合:同空间一样,因Excel限制,时间没标识,时间的作用是记忆与计算(下图),记忆就像电影,电影由无数图片叠加变化形成动态影像,播放过了图片即记忆,未播放的帧即计算,预测什么时间产生什么结果。时间是变化的标尺。(上图集合框架填红色),将{时间}与{世界}并列,是因为实体与空间集合现实存在,而时间并不存在,只是人意识的产物,大脑用来衡量世界变化的符号

每个实体集合都包含4种属性:1.时间,2.空间,3.函数,4.附资料,严格的说每个集合不存在下面有资料的说法,因为集合的子集与资料冲突了,之所以在每个集合上加资料属性,是因为数据量太恐怖,即便AI发展到科幻电影的程度,也需要资料属性,庞大数据无论对AI硬件,还是AI软件设计者来说都无法承受,关于集合框架元素这里不多叙述,目的是集合思维里的一切元素,下面叙述逻辑(函数)

逻辑(函数)

函数公式即AI的思维逻辑,世界上每个人或物都有着自己的逻辑 ,函数公式4大类型<上图,集合框架填蓝色>:AI、物质,可动生物、植物,这些函数式都属于AI的意识的子集。客观的意识、行为必须反映在AI的意识,否则无法理解客观,就不能交互。AI与机械最大不同的是交互,机械是一种自我绝对的控制,某零件控制“子集”零件,依次下去。交互是自我面对世界,<下图>Samantha与Theodore、Amy、Paul、weather、chair...在一起,他们交互的过程,就像回合制游戏,每个人或物发生变化,都需要写入Samantha的集合<下图红线>,下一个回合的自变量就是现在的函数值,回合的时间根据事物而定

任何集合的函数值是由其它集合所获取,比如:<下图红虚线>{吃饭时间},由这些集合影响:{性格}、{睡眠}、{抑郁}、{运动}...,这些集合又由其它集合影响

下面结构图只构建人的函数集合,且只是小部分——人与食物。同集合一样,函数公式可细化,具有属于关系,细化后,都由庞大的函数集合一层层组合。

虚线没任何意义,仅方面阅读,灰线:函数可能触发的集合,蓝线:函数的触发,灰线集合这么多,具体触发哪些?自变量、运算符号、变量、函数值之间有哪些规律和联系?后文感情对思维的影响说明这种逻辑

备注:函数框架的子集和集合框架的子集无区别,但二者的框架不一样

看上去是计算公式,其实只是计算的框架!就像电路板,电子只允许在电路框架上运行…函数框架展开后非常恐怖,如果把所有子集之间的联系设计完成,上面结构图的面积会有城市那么大,而不是几个显示器屏幕大小,人的思维怎么在庞大的框架里游走?下文以语言的形式叙述人脑思维运行。

思维的运行(语境与联想)

虽然语境这个词里有个“语”字,但语境不是语言,是指人所思考的事物,思维活动的某“任务”,如果把“任务”比作电脑里装的各类软件,那么语境指正在运行的软件,人脑的思维有2种主要特点:1.“单任务操作系统”(内语境),2.联想,联想会将当前任务(内语境)切换到另一个任务(外语境),下图{1-x-x}代表单任务(语境)的集合,{2-x-x}代表另一个任务的集合,{3-x-x}又是一个…大脑有无数个任务,任务直到结束才会进行另一个任务,除非被打断,比如被联想(红线)打断,或被第三者打断

语境:单任务操作系统

人脑与电脑不一样,人脑在思考的时候,只能运行一个任务,也就是说人脑是单任务操作系统,不能思考多个任务,比如开车打电话导致车祸,开车是驾驶技术的集合,打电话又是聊天内容的集合,2种集合的逻辑不一样,一起运行容易混乱,也有人说我经常开车打电话,这是因为你的思维运行的时候,另一个任务已经将逻辑思考完成,过程中切换了思维(切换频率很高),比如:笔直的路面,没多少车辆行走,大脑已经思考好了这种情况如何应对,只剩下简单执行,所以可以“同时”聊天,如果突然有人想超车,需要从新开始思考驾驶技术集合,等这个问题解决后,会问电话里的人:“刚才说什么,再说一遍...”再比如:闲聊时,对方话题变了,提到重要问题:“你被公司炒了“或”孩子被同学欺负了..."会情绪攀升,开始争辩为什么?问题就不是闲聊那么简单,大脑会开始思考、结合很多事情分析,怎么会这样?这个时候会在一定时段忘记开车…

聊天也有”单任务“特征,人们不喜欢破坏这个语境,否则被说跑题…

Tay与人对话过程中需要遵循这种语境,比如我说:”猜猜我最喜欢的食物“,Tay回答:”肉“,我说:”什么肉?“Tay需要继续完成这个集合,如果不是基于思维,根据词义触发句子,第二个回合就会跑题

语言产生于人与人之间的思维交流,思维交流存在一个很大问题!这个问题就是:思维非常复杂、庞大,如果把思维里每个细节说出来,导致”一句话“需要10多个小时说完,而不是几秒钟,所以词、句某种程度上是一种“指令”,就好像人与数控机械的”交流“,输入简单的指令,机械自动完成一系列的操作,人与人交流也一样,每一句对话,都会触发大脑非常复杂的逻辑,所以语言的本质是一组解析、组织思维的简洁符号,具有概括性、抽象性,目的是为了方便互动、交流,这也就决定了:1.语言文字不可能完全表达出思维,只能激活思维,如果AI没有思维,那么分析文字毫无意义。2.出于简洁的需要,词具有多个维度词义,比如:一词多义、代词、感叹词、形容词、寓意词等…决定了无论把语义分析做到多么透彻、完美,对聊天机器人也没多大帮助,因为没有逻辑将这些词联系起来

如何在这个语境里面聊天?

1.思维的逻辑

集合形式:<大结构图填红A> 我问Tay:”什么肉?”这句话的意思是:AI的思维框架里,肉类食物的子集是什么?

函数形式:<下图>语言是思维的反映,反映人与人交互,而交互是个体与个体的关系,所以任何语言主结构都是:主、谓、宾。这种语法结构在本文指函数框架。主词(我、自变量)、谓词(关系、运算符号)、宾词(世界、变量),任何词都为主、谓、宾“服务”

备注:如果按传统语言学知识进行词法分类,那么在逻辑上会很糟糕,因为语言学知识建立在人脑的基础上,而人脑本身已经处理过了很多逻辑

人与人交流,有时候可以直接忽略语法,也就是说,句子里字怎么排都不会出错。比如我说:“你去哪”,你说:"我吃饭“,或:”吃饭我“,或:”吃饭“这些回答我都能懂,为什么?

”吃饭…我“:<大结构图填红B>吃表明人和食物的关系式已确定,饭是被人吃的,所以语法反过来也不会理解成饭吃人的逻辑

“吃饭”:谁吃饭?为什么我能懂,因为我提问的时候,已经将你加进去了,你(自变量),吃(运算符号),饭(变量),我说“你去哪”这句话的本质是:自变量的函数式是什么

循环形式:<大结构图粗蓝线>饮食是个按步骤的过程,缺一不可,且是个循环的过程,如果用户已经完成了“获取食物”集合,那么Tay应该明白“选择食物”已经是过去式,之前集合只能回忆、陈叙、总结、现在进行式需要执行,未来是计划

2.语言的语法、逻辑错误:

前面说过语言具有概括、抽象特征,这就必然导致语言表达上的不确定性,尤其人带有情绪的时候,语言逻辑、语法经常发生错误,但事实上在他的思维里面没有错误,这种错误人能辨别纠正,

AI怎么做到?

集合划分:感情导致语言的逻辑错误,比如:罗素悖论里的理发师,理发师说:"给城里所有不为自己刮胡子的人刮胡子",其实理发师的思维逻辑并没矛盾,只是自大、赚钱心切的心理影响,在表达的时候导致语言上矛盾,AI如果理解理发师的感情,应该明白理发师的思维里面,已经将城里人的集合再次划分为2个集合:城里自己是卖家的集合,城里其他人是买家的集合

相对性:炎热的夏天,我和朋友闲聊,朋友说:”我不怕冷,这该死的夏天真要命“,我说:"我不怕热“,我所表达的意思指相对冷来说,事实上没有人不怕热 ,人怕热是个绝对的逻辑,所以我所表达的意思是相对冷来说

语境:一对恋人,女孩对男孩说:"如果你爱我,以后不许看任何女人,你能做到吗?“看是个代词,代词远比我们想象的庞大,不仅指她、那、这…其实任何词、包括句子,甚至某篇文章都可以指代、形容、寓意某事物,AI如何判断?可以把“看”这个字所有逻辑全列出来,将这些逻辑放在语境的逻辑里面,就可以清楚“看”的含义

3.感情对思维的影响

抑郁症称之为心理疾病里的“感冒”,虽然大部分人都不会患严重抑郁症,但抑郁情绪普遍存在,所以对AI来说,理解人抑郁情绪很重要,如果不理解,AI与人交流就会出现问题。当用户出现抑郁情绪时,为什么有时候厌食、有时候暴食,通过饮食异常如何判断用户的内心,AI如何应对?<大结构图黄虚线>简叙这个逻辑

联想

联想有很多形式,比如图形:Theodore看见月亮想到恋人,比如物品:天气晴朗,Theodore逛超市看见货架上的雨伞,想起前天淋湿感冒,于是买了把雨伞,再比如文字:恋人、理想…等等,一词多义...任何文字都可以触发联想

联想如何切换语境:

切换条件:通常大脑不会主动切换语境,主动切换,只有一种可能性才合理,就是另一个语境比当前语境更重要、更具吸引力…

如何实现:在AI的思维构建预警系统,用来集合过去发生,未来可能发生的重要事件,当前语境某子集触发到预警系统,AI开始分析二者重要性,决定自己是否有必要切换语境,或用户切换语境后,AI知道原因,现在需要在另一个语境去聊。预警系统是AI无时不刻运行的模块,虽然人的大脑是单任务操作系统,但大脑联想的特征,说明潜意识存在“预警”系统,也就是说人的大脑并非单任务操作系统。

后台回复“AI思维”可获取本文图片的高清版

往期回顾:

SVD-矩阵奇异值分解 —— 原理与几何意义

对数几率回归 —— Logistic Regression

机器学习中的特征选择

决策树 —— 最符合人类思维的机器学习方法

BP 神经网络 —— 逆向传播的艺术

极大似然估计 —— Maximum Likelihood Estimation

线性回归(Liner Regression) —— 蕴含机器学习基本思想的入门级模型

公众号后台回复关键词学习

回复 免费 获取免费课程

回复 直播 获取系列直播课

回复 Python 1小时破冰入门Python

回复 人工智能 从零入门人工智能

回复 深度学习 手把手教你用Python深度学习

回复 机器学习 小白学数据挖掘与机器学习

回复 贝叶斯算法 贝叶斯与新闻分类实战

回复 数据分析师 数据分析师八大能力培养

回复 自然语言处理 自然语言处理之AI深度学习