版本:IBM InfoSphere DataStage V11.5.1

操作系统:linux redhat 6.4

平台:Apache Hadoop 2.6.0-cdh5.9.0

介绍:

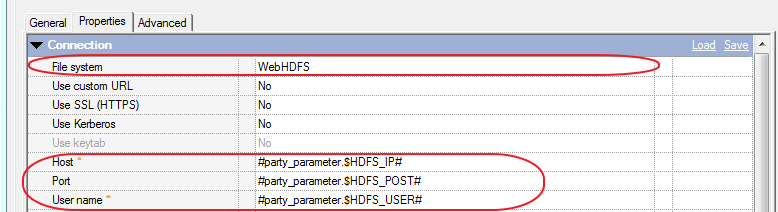

在DataStage中,可通过File Connector组件或Big Data File组件来连接Hadoop平台,从而将传统RDBMS数据库或本地文件中的数据加载到HDFS。比较而言,Big Data File组件支持IBM BigInsights,提供更佳的读写性能;而File Connector组件则通过WebHDFS接口或HttpFS接口访问HDFS,不依赖于Hadoop的品牌和版本,提供更广泛的兼容性。

控件介绍:

FileConnector是DataStage v11.3面向Hadoop的全新组件,提供以下功能:

- 可用于读/写Hadoop文件系统(HDFS)

- 支持并行处理和线性扩展

- 不需要安装其他Hadoop客户端软件包

- 支持Kerberos认证

- 支持SSL安全访问协议

- 支持Knox gateway

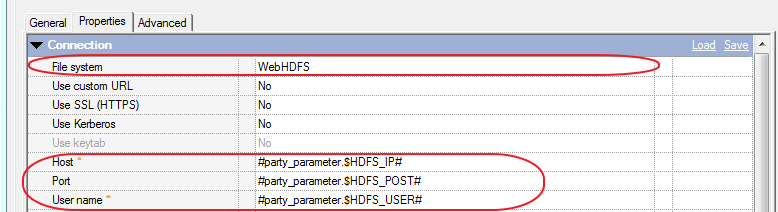

- 支持通过WebHDFS,HttpFS方式访问Hadoop

- 支持访问本地的Hadoop节点

- 更全面的支持Hadoop(不依赖于其版本变更)

样例1:

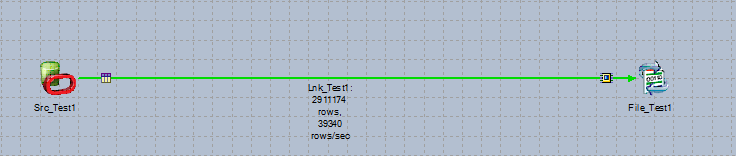

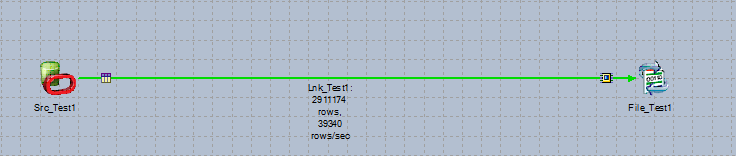

将Oracle 数据源的数据写入下HDFS 中,作业开发:

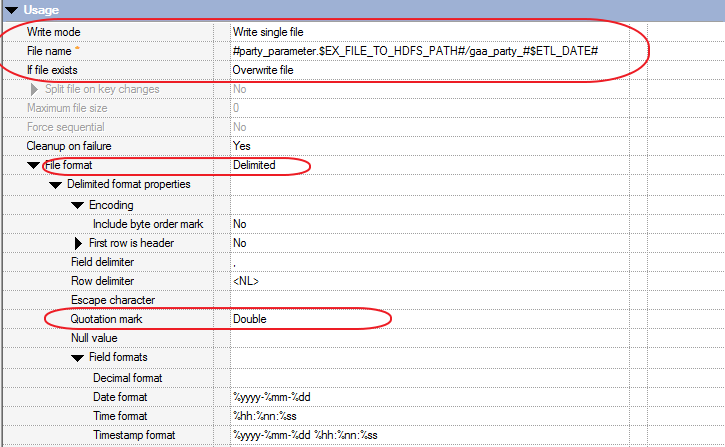

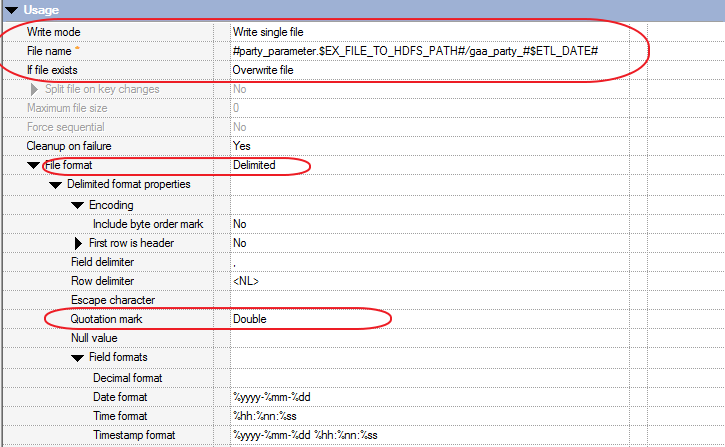

其中FileConnector 控件配置:

写入模式:可以选择单个文件,也可以选择多个文件。

写入文件格式:可以选择CSV格式,也可以选用界定符

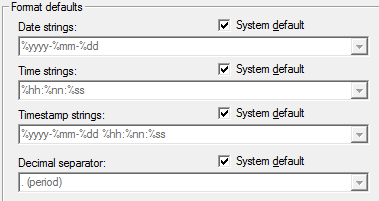

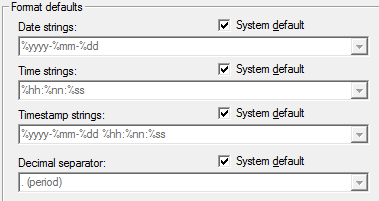

对于Date 类型和 TimeStamp格式需要统一:

DATE FORMATE:%yyyy-%mm-%dd

TIME FORMAT:%hh:%nn:%ss

TIMESTAMP FORMATE:%yyyy-%mm-%dd %hh:%nn:%ss

可以在Administrator --Parallel---Format defaults 中查看如下:

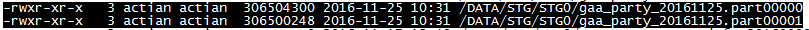

写入方式可以选择多个文件存储可以在HDFS 下查看结果如下: