kettle与hadoop配合使用

0

最近要做的一个项目任务是这样的:

有大量原始数据(百万条以上),需要对这些数据清洗之后再做一个聚类分析,现在目标是kettle跟hadoop结合使用。

我的思路是:利用kettle中hadoop控件将源数据存储在hdfs上(分布式结构存储,利用map-reduce实现),然后kettle利用hadoop相关控件实现聚类分析(同样是map-reduce实现)。

问题是:我不知道kettle中哪个控件是实现这方面功能的。

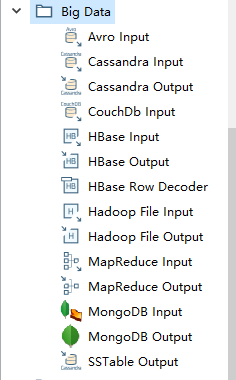

转换里big data控件是

这其中mapreduce input和mapreduce output空间怎么使用?

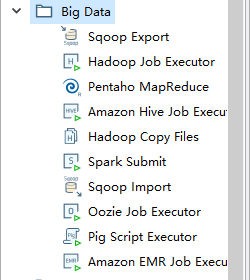

job里big data空间是

Hadoop Job Executor 和 Pentaho MapReduce 又该如何使用?

我不知道我的思路对不对?或者哪位大神能有详细的思路?要是能有具体的转换文件或job文件就更好了。。。

有大量原始数据(百万条以上),需要对这些数据清洗之后再做一个聚类分析,现在目标是kettle跟hadoop结合使用。

我的思路是:利用kettle中hadoop控件将源数据存储在hdfs上(分布式结构存储,利用map-reduce实现),然后kettle利用hadoop相关控件实现聚类分析(同样是map-reduce实现)。

问题是:我不知道kettle中哪个控件是实现这方面功能的。

转换里big data控件是

这其中mapreduce input和mapreduce output空间怎么使用?

job里big data空间是

Hadoop Job Executor 和 Pentaho MapReduce 又该如何使用?

我不知道我的思路对不对?或者哪位大神能有详细的思路?要是能有具体的转换文件或job文件就更好了。。。

没有找到相关结果

重要提示:提问者不能发表回复,可以通过评论与回答者沟通,沟通后可以通过编辑功能完善问题描述,以便后续其他人能够更容易理解问题.

0 个回复