概述

1. HDFS集群分为两大角色:NameNode、DataNode (Secondary Namenode)

2. NameNode负责管理整个文件系统的元数据

3. DataNode 负责管理用户的文件数据块

4. 文件会按照固定的大小(blocksize)切成若干块后分布式存储在若干台datanode上

5. 每一个文件块可以有多个副本,并存放在不同的datanode上,一台datanode只会有一个副本,如果当前副本为3,但是只有2个datanode,则副本为2,等datanode扩展到3台的时候才会自动复制副本到新增服务器,副本数才变为3。

6. Datanode会定期向Namenode汇报自身所保存的文件block信息,而namenode则会负责保持文件的副本数量

7. 客户端请求访问HDFS都是通过向namenode申请来进行

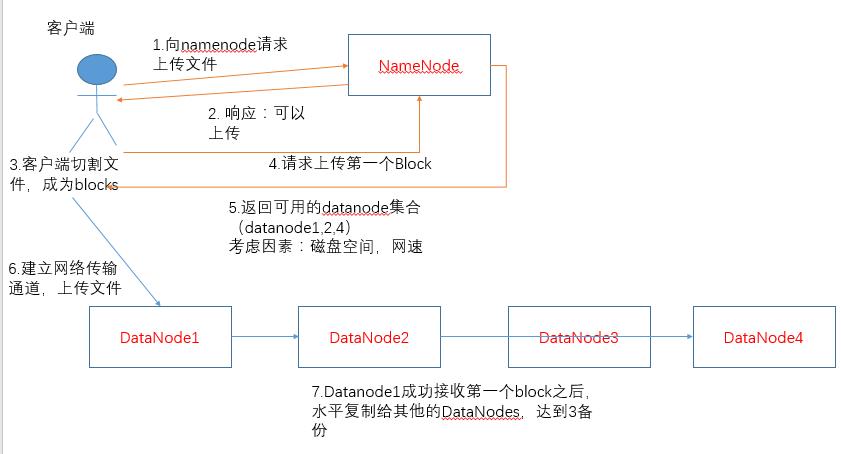

HDFS写数据概述

客户端要向HDFS写数据,首先要跟namenode通信以确认可以写文件并获得接收文件block的datanode,然后,客户端按顺序将文件逐个block传递给相应datanode,并由接收到block的datanode负责向其他datanode复制block的副本

HDFS写文件,每次上传一个block,都要循环执行下面的图。需要注意的是

(只要上传成功一台datanode就算成功了,如果后续机器失败,namenode会帮忙调度datanode的数据迁移)

HDFS读数据概述

概述

客户端将要读取的文件路径发送给namenode,namenode获取文件的元信息(主要是block的存放位置信息)返回给客户端,客户端根据返回的信息找到相应datanode逐个获取文件的block并在客户端本地进行数据追加合并从而获得整个文件