NIPS 是机器学习领域的顶级会议之一,类似等级的顶级会议还有CVPR, ICCV, ICML, CIKM,IJCAI等。

本次摘读论文题目是:Swapout: Learning an ensemble of deep architectures

获取论文→https://arxiv.org/pdf/1605.06465.pdf

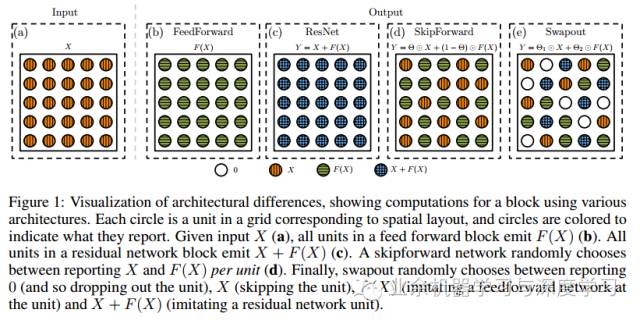

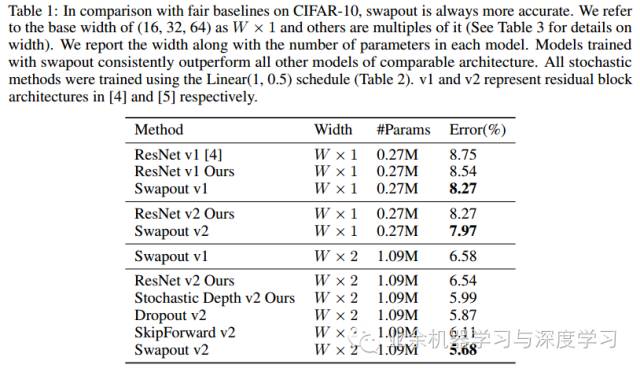

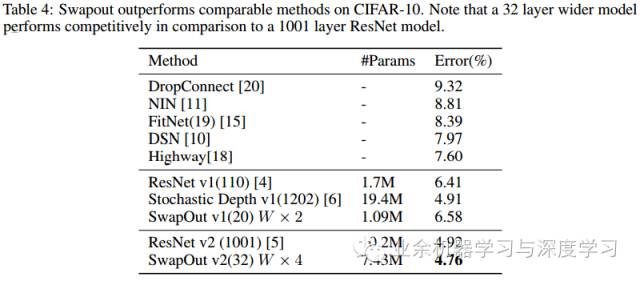

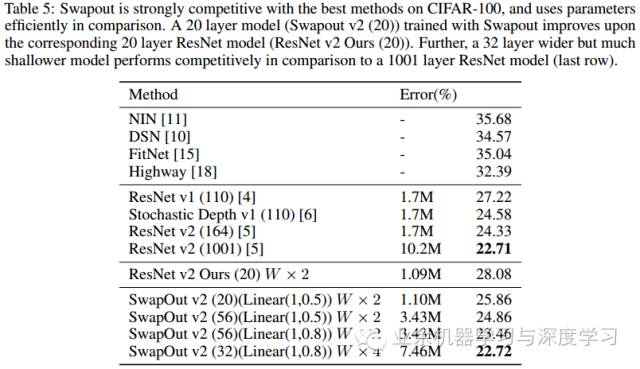

在NIPS 2016中, 来自伊利诺伊大学香槟分校的学者提出了swapout, 它是一种随机循环方法,在同样网络结构下,Swapout在数据集CIFAR-10 和 CIFAR-100上取得的效果优于ResNets。Swapout会在一个比较丰富的结构集合中采样,其中包括dropout,随机深度[6]和残差结构等。 Swapout可以看作一种正则化方法,不仅可以抑制同层单元的协同效果,这点跟dropout类似,而且可以抑制不同网络层之间的协同效果。Swapout通过约束层间的参数可以达到正则化的效果。Swpapout也可以看做一种集成训练方法,它可以从一个比较丰富的结构集合中采样,相比现存方法dropout和随机深度方法而言,集成方法有很多种。令人震惊的是,采用swapout技术的32层比较宽的网络所能达到的性能能够比得上1001层的ResNet模型所取得的效果。

Swapout是对dropout和随机深度方法的泛化。Dropout即为在训练过程中将输出单元的取值随机置零,而随机深度方法在训练过程中随机跳过整个层。一般的swapout网络中同一层中每个输出单元的取值是相互独立的。对于同一层的单元,有些单元跟一般的前向传播网络中的单元类似,有的单元对应的连接不是全连接,而是具有间隔的连接,还有一些单元可能是对处在更前面的层中输出求和得到。

说了这么多,还是感觉一图胜千语,来来来,看看swapout到底是什么鬼:

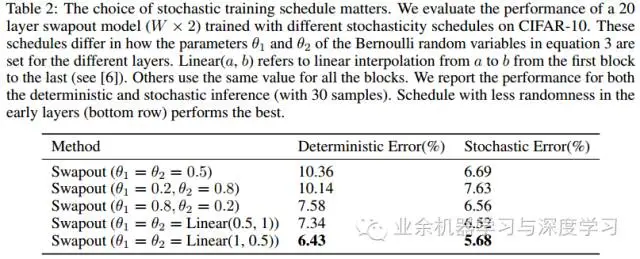

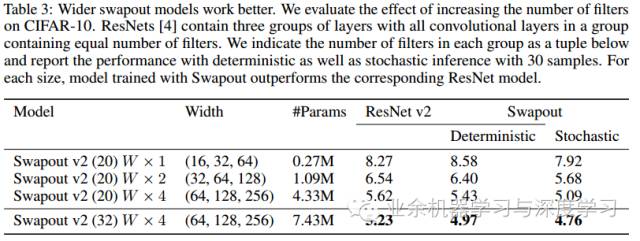

知道了Swapout到底是什么鬼,接下来看看实验结果:

参考资料

ResNet:

K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning for image recognition. CoRR, abs/1512.03385, 2015.

K. He, X. Zhang, S. Ren, and J. Sun. Identity mappings in deep residual networks. CoRR, abs/1603.05027, 2016.

Stochastic Depth:

G. Huang, Y. Sun, Z. Liu, D. Sedra, and K. Q. Weinberger. Deep networks with stochastic depth. CoRR, abs/1603.09382, 2016

DSN:

C.-Y. Lee, S. Xie, P. Gallagher, Z. Zhang, and Z. Tu. Deeply-supervised nets. AISTATS, 2015.

NIN:

M. Lin, Q. Chen, and S. Yan. Network in network. CoRR, abs/1312.4400, 2013.

Fitnets:

A. Romero, N. Ballas, S. E. Kahou, A. Chassang, C. Gatta, and Y. Bengio. Fitnets: Hints for thin deep nets. ICLR, 2015.

Highway:

R. K. Srivastava, K. Greff, and J. Schmidhuber. Training very deep networks. In NIPS, 2015.