日常使用Hive时候 经常出现中文乱码问题 在此总结下

MySQL大量数据插入Hive时,一般两种情况:手动导入Hive或者用Python代码(基于python2)

一.MySQL数据中文手动插入Hive

手动导入数据:

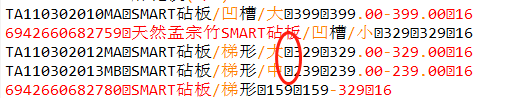

1.从MySQL拉数据就毋庸叙述了,注意导出的时候不要加入列名,Hive插入数据的时候直接插入数据

2.需要注意建表时候每个字段的间隔的字符,不知道的话可以先下载Hive上一部分数据看看间隔字符,然后替换间隔字符

insert overwrite local directory '/home/chris/test/' select * from mall_prd_prod; #注意test下不要放文件 会全部被清理删除掉

3.上传数据,进入Hive写入命令

load data local inpath '/home/chris/test/000000' into table mall_prd_prod;

如果字符出现问题,可以使用UE转换utf-8编码后插入数据

二.使用Python把数据的中文插入Hive

使用集群的pyspark把MySQL数据插入Hive,代码如下所示

import pymysql

import pandas as pd

conn=pymysql.connect(host='192.168.12.118',user='root',password='123456',database="items_recommend")

cur=conn.cursor()

cur.execute("select item_cate_id,item_hot from ezr_items_hot limit 10")

data=cur.fetchall()

conn.close()

data=pd.DataFrame(list(data))

data.columns=['item_cate_id','item_hot']

from pyspark import SparkContext,SparkConf

from pyspark.sql import HiveContext

conf = SparkConf().setAppName(u'recommend')#.setMaster("local[*]")

sc= SparkContext.getOrCreate()

hive_context = HiveContext(sc)

hive_context.sql('use pro37')

df=hive_context.createDataFrame([(data.iloc[0].item_cate_id,float(data.iloc[0].item_hot))],['item_id','item_hot'])

df.registerTempTable("df")

hive_context.sql("insert into table ezr_items_hot select item_id,item_hot from df")

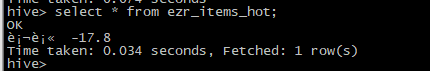

得到的结果中文存在乱码,Hive查询结果:

这时候需要把unicode格式中文转换成utf-8后再插入Hive

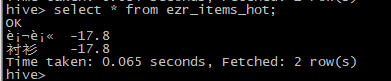

此时可以看到插入数据编码格式OK了